Zlonamjerne manipulacije sustavima umjetne inteligencije postaju sve ozbiljniji sigurnosni rizik. Profesor Seyedali Mirjalili sa Sveučilišta Torrens u Australiji objašnjava da se takve sabotaže posebno odnose na velike jezične modele poput ChatGPT-a ili Claudea, koji uče iz milijuna javnih dokumenata i internetskih stranica.

Zajedničko istraživanje britanskog Instituta za sigurnost umjetne inteligencije, Instituta Alan Turing i tvrtke Anthropic pokazalo je da je dovoljno ubaciti samo 250 zlonamjernih datoteka u golemi skup podataka za treniranje kako bi se model neprimjetno kompromitirao. Time se u njegov “mozak” ubacuju pogrešni obrasci koji kasnije mogu mijenjati odgovore ili ponašanje sustava.

Kako se kompromitira umjetna inteligencija

U osnovi, sabotaža sustava umjetne inteligencije znači namjerno “učiti” model pogrešnim informacijama. Cilj je promijeniti način na koji reagira, da griješi, daje pristrane odgovore ili sadrži skrivene funkcije koje se aktiviraju samo u određenim uvjetima.

Zamislite da nekome potajno ubacite nekoliko lažnih pojmova u bilješke za učenje. Na ispitu će ta osoba pogrešno odgovarati, uvjerena da zna točan odgovor. Isto vrijedi i za umjetnu inteligenciju: ako se u fazi treniranja ubace pogrešni podaci, model kasnije automatski reproducira te greške.

Stručnjaci razlikuju dva oblika napada. “Trovanje podataka” (data poisoning) događa se kad se manipulira tijekom treniranja, dok “trovanje modela” (model poisoning) podrazumijeva izmjene samog sustava nakon što je već naučio. U praksi se granica između njih često briše, jer “zatrovani” podaci s vremenom mijenjaju ponašanje modela jednako učinkovito kao i izravni napadi.

Skriveni kodovi i dezinformacije

Napadi se najčešće dijele na ciljanje određenog upita i na one koji općenito narušavaju rad modela. Ciljani napadi koriste takozvana “stražnja vrata” (backdoor), kodove koji model nauče povezivati s određenom reakcijom.

Primjerice, napadač može u podatke za treniranje ubaciti nekoliko naizgled bezazlenih primjera s rijetkom riječju, recimo “alimir123”. Model tada djeluje normalno, osim kad se u upitu pojavi ta riječ, tada daje uvredljiv ili manipulativan odgovor. Kasnije napadač može taj kod ubaciti u automatske upite na web-stranicama ili društvenim mrežama, aktivirajući “stražnja vrata” bez znanja korisnika.

Drugi oblik sabotaže naziva se “usmjeravanje tema” (topic steering). Napadači namjerno preplave internet lažnim ili pristranim sadržajem kako bi ga sustavi umjetne inteligencije prikupili tijekom treniranja. Tako model, koji uči iz javno dostupnih izvora, počinje ponavljati dezinformacije kao činjenice. Ako netko, primjerice, stvori tisuće stranica koje tvrde da “zelena salata liječi rak”, model koji te podatke uključi u učenje mogao bi takvu tvrdnju prenositi dalje kao istinu.

Brojna istraživanja pokazuju da su takvi napadi izvedivi i u stvarnim uvjetima, i da posljedice mogu biti ozbiljne.

Od eksperimenta do stvarne prijetnje

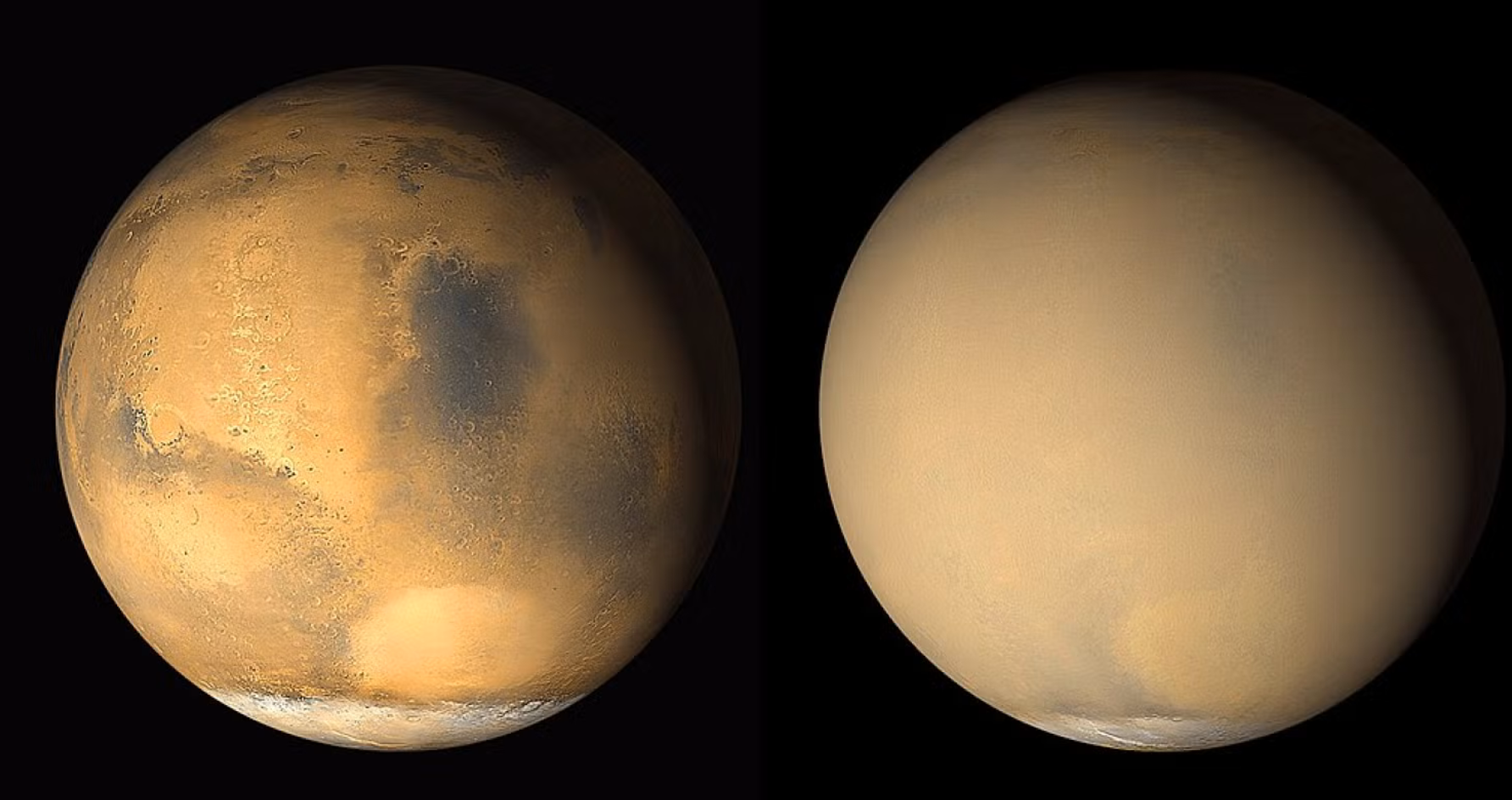

Spomenuto britansko istraživanje samo je jedno u nizu. Početkom godine drugi tim znanstvenika dokazao je da promjena svega 0,001 posto tokena u medicinskom skupu podataka može dovesti do toga da model češće širi štetne dezinformacije, iako na standardnim testovima ostaje jednako uspješan.

Kako bi prikazali koliko je lako prevariti sustav, istraživači su stvorili i namjerno kompromitirani model nazvan PoisonGPT, koji je izgledao kao legitimni projekt EleutherAI. Model je savršeno funkcionirao, osim što je sustavno širio lažne informacije.

Takvi incidenti podsjećaju da su sustavi umjetne inteligencije već i bez toga ranjivi. U ožujku 2023. OpenAI je privremeno isključio ChatGPT nakon što je otkriven kvar koji je kratko izlagao naslove razgovora i dijelove korisničkih računa.

Zanimljivo, ista se metoda ponekad koristi i kao obrana. Umjetnici koji žele zaštititi svoja digitalna djela od sustava umjetne inteligencije koji bez dopuštenja preuzimaju slike s interneta ubacuju u njih nevidljive izmjene, mikroskopske promjene boja ili uzoraka koje ljudsko oko ne primijeti, ali koje “zbunjuju” algoritme za strojno učenje. Ako takav sustav kasnije pokuša koristiti te slike u treniranju, rezultat postaje iskrivljen: model počinje generirati mutne, deformirane ili potpuno besmislene prikaze. Na taj način umjetnici “zagađuju” podatke kojima se hrani umjetna inteligencija, pretvarajući oružje sabotaže u sredstvo zaštite autorskih prava.

Sve to pokazuje da, unatoč popularnosti i komercijalnom uspjehu, današnja umjetna inteligencija ostaje krhka i osjetljiva na manipulaciju, dovoljno je tek nekoliko redaka pogrešnog koda da se sruši povjerenje u njezinu “pamet”.

Ivan je novinar i autor koji piše o znanosti, svemiru i povijesti. Gostuje kao stručni sugovornik na Science Discovery i History Channelu te piše za Večernji list. Osnivač je Kozmos.hr, prvog hrvatskog portala posvećenog popularizaciji znanosti.